Чат-боты GPT и другие: что думают лингвисты о больших языковых моделях

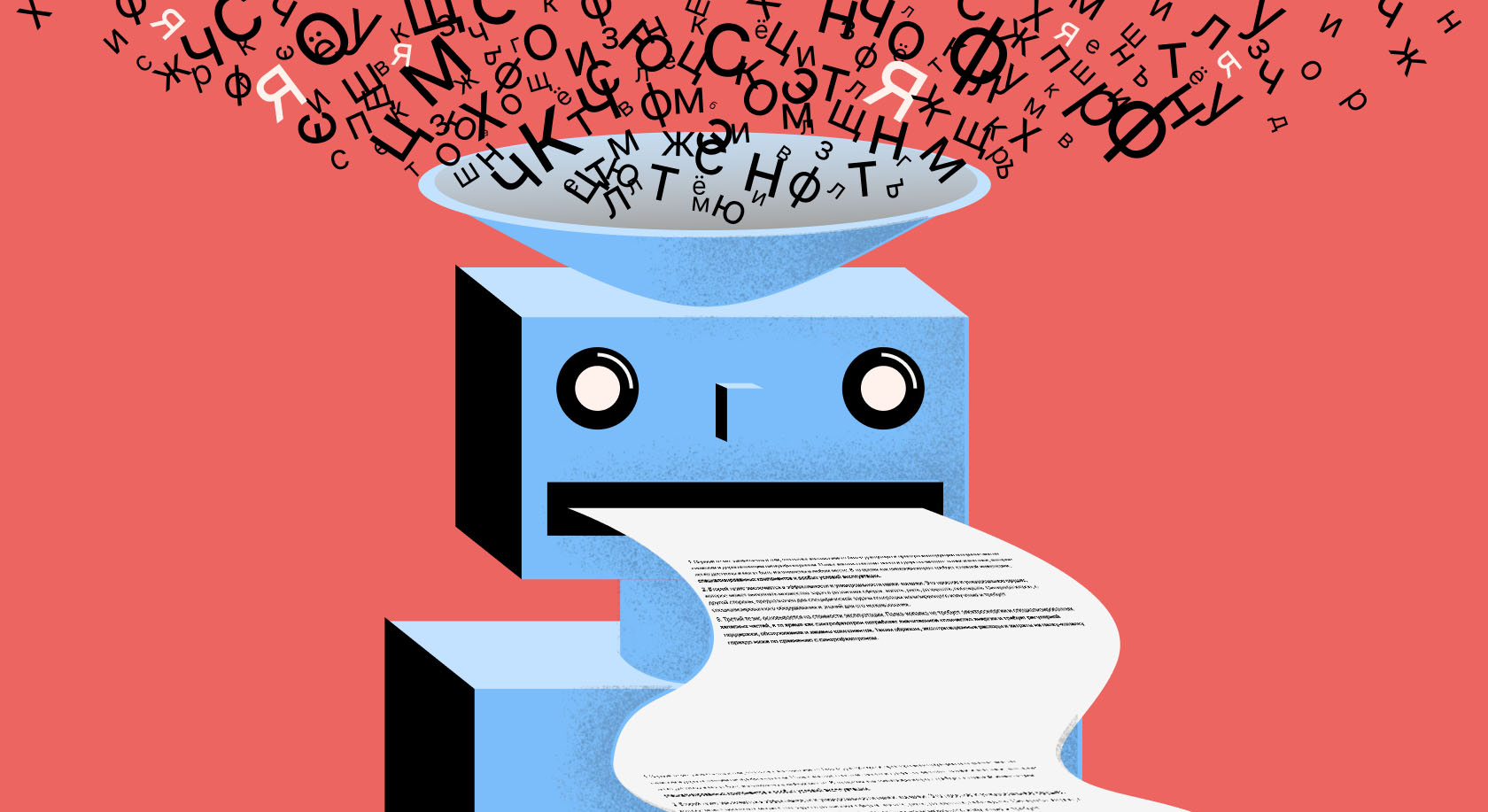

Со второй половины 2010-х годов компьютерные языковые модели совершили революцию в обработке текстов. Они научились осмысленно отвечать на вопросы, делать переводы, писать рассказы и даже романы. Лингвисты восприняли эту революцию неоднозначно: кто-то — с оптимизмом, а кто-то — со скепсисом.

Получившая громкую известность аббревиатура GPT расшифровывается как Generative Pre-trained Transformer — генеративный предобученный трансформер. Это целое семейство компьютерных моделей, которые обучаются на больших объемах данных, используя специальные алгоритмы. Главный из них — опора на контекст: модель запоминает, какие слова чаще встречаются вместе. В результате такие модели могут создавать грамотный и даже осмысленный (с человеческой точки зрения) текст.

Вопросов возникает масса. Как машина понимает, что перед ней не просто набор символов, а слова, предложения, произведения литературы, наконец? Как в процессе обработки машина обретает способность подражать человеку? Как ей удается писать в разных стилях, придумывать целые сюжеты и даже шутить?

Языковой вундеркинд, озадачивший исследователей

Большим языковым моделям (БЯМ) типа GPT всего-то несколько лет, но они уже достигли невероятных успехов. Например, рассказ на русском языке, написанный одной из таких моделей, недавно прошел в финал литературного конкурса, где жюри оценивали работы вслепую. Весной 2023 года студент РГГУ успешно защитил диплом, написанный ChatGPT.

«В современной лингвистике есть два фундамендальных подхода к тому, что такое язык и как он работает, — объясняет руководитель ИИ-направления на Грамоте Михаил Копотев. — Одни считают, что есть набор правил, по которым создается бесконечное количество текстов. Другие исходят из того, что есть вероятности, а правила — лишь частный случай вероятностей. Опираясь на старую оппозицию „язык или речь“, одни считают, что первичен язык, другие — что речь».

Копотев относит себя к представителям второго лагеря. «Я вижу смену лингвистической парадигмы, которую подтверждает и успех языковых моделей, — говорит эксперт. — Сейчас идет поворот в сторону представления, что реальность дана в речи. Есть живая речь с ее спонтанностью, неточностью и, главное, линейностью, самые частотные паттерны которой обобщаются до правил. Но не наоборот».

От правил — к статистике

В самом начале своего существования компьютерная лингвистика шла иным путем. Как объясняет лингвист Александр Пиперски в интервью для подкаста «Полный Гёдель», в 1950–1960-х годах, когда дисциплина только начала появляться, казалось, что достаточно применить традиционные методы описания языка, сделав их более точными, чтобы машина их могла понимать, и добавить какие-то специально введенные понятия, «и машина будет переводить, суммаризировать и порождать тексты».

Вначале компьютерный лингвист писал правила, по которым машина должна была действовать. «Если ты переводишь с русского языка на французский, тебе нужно в словосочетании прилагательное + существительное эти два элемента переставить местами, — продолжает Александр Пиперски. — На этой основе лингвист пишет правило. Есть небольшой список исключений, и нужно четко проанализировать, где и как в текстах прилагательные ставятся. Через несколько дней работы получается хорошее правило: как переводить сочетание прилагательного и существительного с русского на французский».

Однако результаты были скромными. Основанный на правилах машинный перевод хорошо справлялся с переводом простых и однозначных конструкций, но работал гораздо хуже, когда нужно было передать идиоматические выражения и нюансы, которые опираются на широкий контекст. Эту проблему пытались решить, но рывок произошел в 1980-х, когда для компьютерной обработки лингвисты начали использовать статистику.

Стали появляться широко доступные языковые корпусы — большие массивы текстов, которые можно статистически обрабатывать. Правила теперь можно было не формулировать на основе лингвистических знаний, а выводить на основе частотности.

«Если мы переводим то же словосочетание с русского на французский, нам не надо задавать правила, надо посмотреть на много переведенных текстов, — объясняет Александр Пиперски. — Машина может вычленить разные случаи употребления слов и объединить их на основе статистических паттернов».

Чемпионы по выявлению закономерностей

С приходом нейросетевых моделей обработки языка ситуация вновь изменилась и вышла на качественно новый уровень. Новые алгоритмы машинного обучения в сочетании с большей доступностью «железа» оказались способны не только обрабатывать гигантские массивы данных (сотни тысяч литературных текстов и миллионы веб-страниц), которые никогда не сможет просмотреть ни один человек, но и самостоятельно искать закономерности.

«Математические модели находят в тысячи раз больше закономерностей, чем человек, — подчеркивает Михаил Копотев. — Если попросить самого образованного лингвиста, занимающегося русским языком, назвать все свойства одного слова: количество букв, фонемы, грамматические характеристики и так далее, — мы с трудом наберем пару сотен параметров. А GPT «знает» тысячи параметров для каждого слова».

Это связано с тем, как обучаются новые модели: они способны учитывать не только сочетаемость в пределах предложения, но и, например, стилистические параметры целого текста. Более ранние модели в основном учитывали параметры только из ближайшего окружения (например, какие буквы чаще стоят вместе).

В GPT используется архитектура «трансформер», которая присваивает веса элементам текста в зависимости от их значимости для общей структуры. Ее преимущество в том, что удается захватить и далекое окружение: другие слова из предложения, расположение отдельных предложений в абзаце и так далее.

«Модель может учитывать миллионы закономерностей, которые недоступны человеку, — объясняет Михаил Копотев. — Комбинации букв, морфологических параметров, слов — каждому элементу модель присваивает собственный вес. Суммарные веса затем складываются — то есть модель высчитывает общий результат из сочетания разных весов, — и мы получаем в результате то, что получаем: тексты, которые выглядят осмысленно, в которых присутствует логическая связь, определенное стилистическое единство».

При этом модель все равно оперирует вероятностями — например, отвечает на вопрос не потому, что знает ответ, а потому что это самый математически вероятный вариант. Именно поэтому, в частности, модель при ответе на вопрос выдает немного разные тексты: каждый раз веса могут распределиться чуть по-своему. Но по той же причине она несвободна от ошибок: ведь она не связана с фактами и реальным миром, поэтому просто не знает, какая информация правдива, а какая — нет. Онтологическое отличие искусственного интеллекта от человеческого состоит в том, что мы в процессе обучения обобщаем факты реального мира, тогда как машина обобщает тексты, которые могут иметь к реальному миру слабое отношение.

Плагиат, апатия и покорность

В марте 2023 года знаменитый лингвист Ноам Хомский опубликовал в газете The New York Times эссе о ChatGPT, которое наделало много шума. Суть его сводилась к тому, что большие языковые модели дают человечеству «ложное обещание», создавая иллюзию осмысленности. На деле же, считает Хомский, порождение речи человеком и работа машинных моделей коренным образом отличаются, и в этом отличии кроется «банальность зла» последних. Эта отсылка к книге Ханны Арендт, видимо, связана с тем, что GPT тоже является оппортунистом, который просто выполняет команды.

Человеческий разум оперирует значительно меньшими объемами информации, чтобы порождать сложные языковые конструкции. Маленький ребенок, рассуждает Хомский, бессознательно, автоматически и быстро развивает грамматику — потрясающе сложную, но опирающуюся на мизерное количество данных. Эту грамматику Хомский понимает как проявление врожденной, генетически заложенной «операционной системы», которая наделяет человека способностью создавать сложные предложения и длинные цепочки мыслей.

Именно поэтому, по мнению исследователя, возникновение языковых моделей на самом деле не перечеркивает многолетнюю работу лингвистов по изучению языка: они пытаются реконструировать, как эта явная версия грамматики возникает у ребенка в голове, как он инстинктивно и при минимальном воздействии информации производит речь. Машине доступны куда бо́льшие объемы информации и бо́льшая производительность, но пока она все равно не может уподобиться ребенку, считает Хомский.

Машины используют метод грубой силы (brute force) для обработки гигантский объемов информации. Они лишь «экстраполируют наиболее вероятностный разговорный ответ», но не способны объяснять и творчески размышлять. «ChatGPT и подобные программы, по замыслу, не ограничены в том, что они могут „выучить“ (то есть запомнить); они не способны отличить возможное от невозможного», — считает Хомский.

В отличие от людей, которые наделены универсальной грамматикой, ограничивающей языки, которые мы можем выучить, обладающие почти математической элегантностью, эти программы с равным успехом учат возможные и невозможные человеческие языки.

Именно поэтому, по мнению исследователя, предсказания систем машинного обучения всегда будут поверхностными и сомнительными. Их удел — «плагиат, апатия и покорность». Пока большие языковые модели лишены фундаментального понимания языка, они обречены на подражание. А значит, они могут в равной степени «узнать» о том, что земля плоская, и о том, что она круглая. «Они „торгуют вероятностями“, которые постоянно меняются», — подытоживает Хомский.

Риски и достоинства

Большие языковые модели GPT действительно ведут себя оппортунистически, соглашается Михаил Копотев. «От того, какого типа тексты к ним поступают, зависит результат, — размышляет он. — Модель принимает все как равноправное. Например, я попросил ChatGPT дать описание какого-нибудь героя русской литературы, а потом сказал системе: ты ошиблась, ты описала другого героя, — и она тут же согласилась, хотя описание было очень точным. У нее нет собственной позиции ни по одному вопросу».

С этим связан и огромный масштаб возможных злоупотреблений: модели GPT могут эффективно порождать тексты для любых задач, но у них нет осознания ответственности.

Модель открывает ящик Пандоры в смысле создания дешевых и эффективных текстов. Можно представить, что какая-то компания будет использовать их для продвижения опасных продуктов.

Другой пример — плагиат. Уже сейчас есть много историй, когда студенты создавали эссе, курсовые и даже дипломы с помощью инструментов GPT. Впрочем, некоторые вузы предпочитают не бороться с их использованием, а внедрять их в качестве вспомогательного инструмента. Так, недавно Ученый совет Московского городского педагогического университета (МГПУ) разрешил студентам использовать искусственный интеллект при написании выпускных работ.

«Я за то, чтобы активно внедрять эти технологии в классе, — подчеркивает Михаил Копотев. — И Хельсинкский университет, в котором я работаю, поощряет студентов использовать новые технологии, чтобы они адаптировались к миру, в котором им предстоит жить. Ведь вполне вероятно, что все текстовые редакторы скоро будут использовать эти инструменты. Например, мы будем писать текст и выбирать опции „переработай его в таком-то стиле“, „проверь ошибки“, „исправь стилистику“».

По мнению Копотева, это можно считать огромным шагом к демократизации языка: «Если, к примеру, мигранту нужно написать заявление в госорганы, но он не владеет бюрократическим стилем, система на основе ИИ напишет ему заявление за минуту. Другой пример — расширение возможностей людей, которым когнитивные или другие особенности мешают создавать тексты».

Лингвистика эпохи БЯМ

Большие языковые модели могут помочь лингвистам лучше понимать структуры и системы внутри языка. По мнению Михаила Копотева, все ранее неучтенные параметры сочетаемости, которые видит машина, можно со временем вычленить и включить в инструментарий специалистов.

Пусть пока это черный ящик, но это не значит, что так будет всегда.Наша задача как лингвистов этот ящик вскрыть и показать, какие параметры важны и что ценного они могут нам сказать про язык.

Лингвисты, в свою очередь, могут помочь программистам в совершенствовании моделей. «Сейчас работа моделей избыточна, — объясняет эксперт. — На их работу тратится колоссальное количество ресурсов — вычислительных и денежных. Часть информации, которая в них хранится, суперважна, другая часть менее важна или это информационный шум, но тонкая приоритизация сейчас отсутствует: система просто знает, что одно событие более вероятно, чем другое».

Используя системные знания о языке и знания о мире, лингвисты могут определить, на какую информацию нет смысла тратить ресурсы, и сообщить об этом специалистам по искусственному интеллекту. «Такой обмен и обогащение, я думаю, и будут происходить в ближайшие годы, — считает Михаил Копотев. — Нас ожидают и новые лингвистические открытия, и новые продукты на этом рынке».

Еще на

эту тему

Владимир Плунгян: «Первый урок корпуса — не злоупотреблять нормализаторством»

Корпус учит лингвистов не доверять своей интуиции и изучать те явления, которые встречаются часто

Нейросеть YandexGPT научилась пересказывать тексты на русском языке

Технология поможет при подготовке докладов и обзоров

«Говорим по-русски!»: ChatGPT и другие нейросети

Новый выпуск программы