Новый подход поможет людям более успешно общаться с большими языковыми моделями

Большие языковые модели — подобные тем, что используются в чат-ботах ChatGPT и других — могут писать рассказы, создавать контент-планы для соцсетей и даже шаблоны юридических документов. И все это — по запросу пользователя на обычном (естественном) языке.

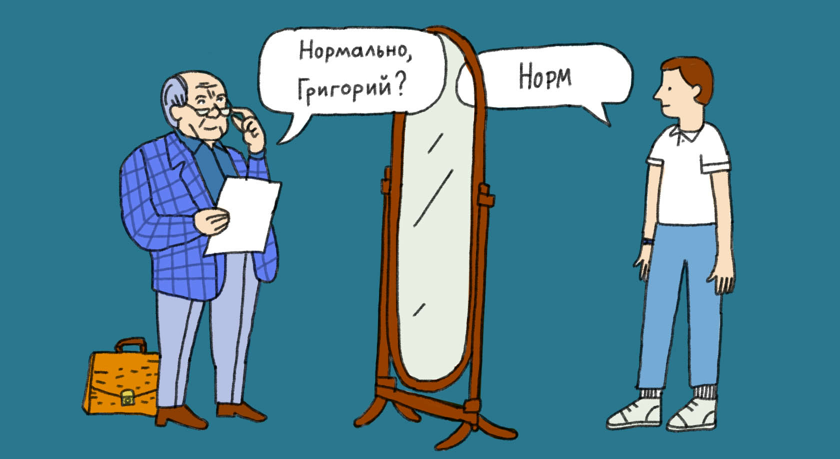

Но с операциями, требующими вычислений, модели справляются куда хуже. Почему? Дело в том, что языковая модель обучена на текстовых данных, которые для нее — просто данные. Буквы соединяются в слова и предложения, потому что модель оценивает вероятность такого сочетания. Но она не оценивает достоверность и точность указанных сведений.

Возьмем, например, вопрос Какие президенты США, избранные после 1950 года, родились в среду?. Языковая модель, которая полагается на вероятность (что в изученных ею текстах где-то уже есть нужное сочетание), скорее всего, ошибется. Получить ответ можно с помощью других программ.

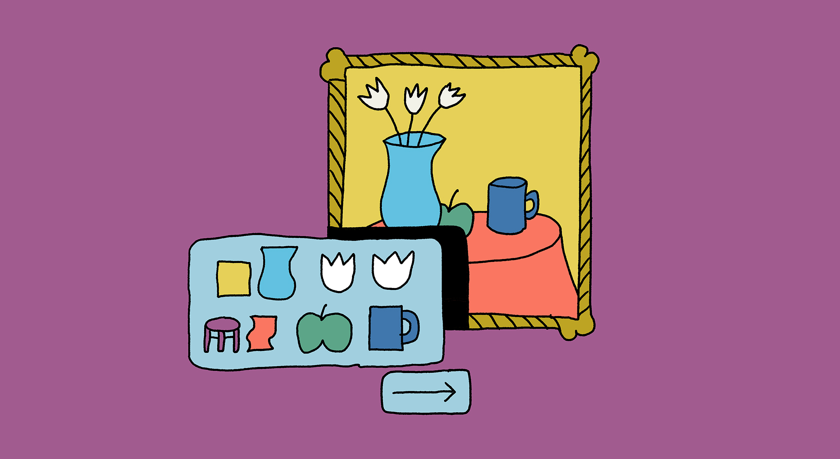

Исследователи из Массачусетского технологического института (MIT) предложили подход, который помогает языковым моделям преодолеть это ограничение. Этот подход, названный встроенными программами на естественном языке (Natural Language Embedded Programs, NLEPs), позволяет отправить модели инструкцию (промпт) на естественном языке, чтобы та создала и запустила программу на языке Python, а затем представила результат на естественном языке.

Опыты группы разработчиков из MIT показал, что NLEP позволяет большим языковым моделям достигать бо́льшей точности при решении широкого спектра задач, связанных с логическими операциями. При этом созданные ими промпты универсальны, их можно использовать повторно для других аналогичных задач.

Комментарий Бориса Орехова, кандидата филологических наук, руководителя образовательной программы «Цифровые методы в гуманитарных науках» НИУ ВШЭ:

«Путь, которым идут разработчики, преследует сразу две цели. С одной стороны, таким образом инженеры пытаются победить широко известную проблему больших нейросетей — „галлюцинации“, то есть неверные ответы, которые исходят из явно некорректных представлений о предмете. Разработчики остроумно пытаются сменить основной узел выполнения задачи: им становится не предсказатель наиболее вероятного порядка слов в тексте, а компьютерная программа с четким алгоритмом.

С другой стороны, здесь есть стремление повысить понятность (интерпретируемость) для человека того способа, которым решается задача. В принципе, в нейросетях нет ничего загадочного, мы понимаем, как они устроены и как работают, но так как при решении каждый раз задействуются миллиарды нейронов, не всегда можно проследить, что и как сработало в каждом конкретном случае. И это вызывает у исследователей дискомфорт и непонимание, что именно стоит улучшать в будущем.

Способы победить „галлюцинации“ (например, путем интеграции с базами знаний) в последнее время множатся. Мы ожидаем, что скоро найдется наиболее эффективный, и нейросети больше не будут выдавать смешные абсурдные ответы. Способы сделать решения, которые принимают нейросети, более прозрачными, тоже стали появляться сравнительно давно (Explainable AI). Здесь они объединились».

Еще на

эту тему

Как отличить текст, написанный нейросетью? Ряд критериев предложен на «Хабре»

ИИ не способен к оригинальному мышлению и творческому осмыслению информации

Приличное поведение больших языковых моделей может быть обманчивым

Попытки перевоспитать «спящих агентов» только ухудшают ситуацию

Чат-боты GPT и другие: что думают лингвисты о больших языковых моделях

Впереди демократизация порождения текстов и большие риски злоупотреблений