Исследование: внутренний язык больших языковых моделей ближе всего к английскому

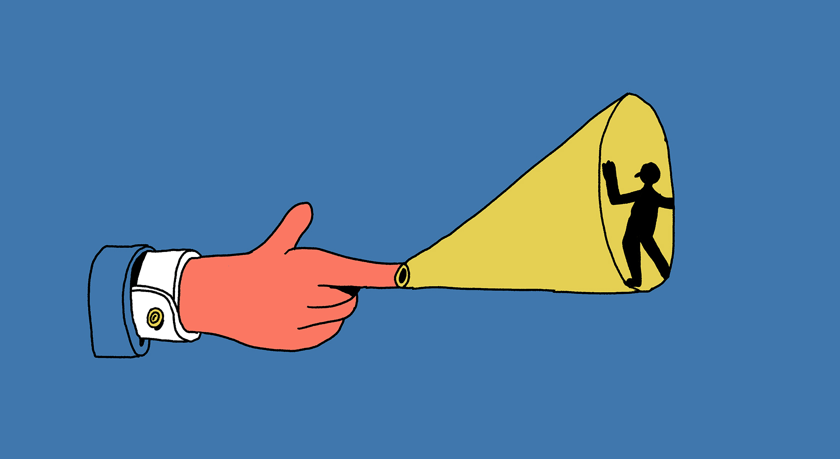

Большинство нейросетевых языковых моделей обучаются на огромных массивах данных — в основном англоязычных, так как текстов на этом языке больше всего. При этом модели — если их дообучить — вполне могут генерировать тексты на других языках и делать переводы на эти языки, несмотря на то, что данных на этих языках, пригодных для обучения моделей, значительно меньше. Языковым моделям удается обходить эти ограничения благодаря тому, что они используют английский в качестве языка-посредника. Но это чревато искажениями — как в деталях, так и на уровне языковых концептов.

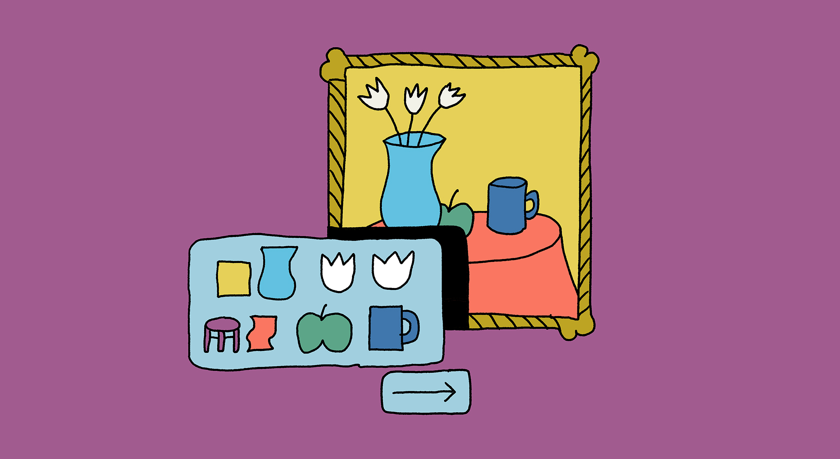

Исследователи из Федеральной политехнической школы Лозанны провели эксперимент. Языковая модель Llama-2 с открытым исходным кодом должна была решать разные задачи (например, перевести серию французских слов на китайский), а исследователи пытались разобраться, как именно она это делает. Авторы работы пришли к выводу, что в значительной части случаев в последовательности состояний, ведущей от французского «входа» к китайскому «выходу», возникало английское слово, хотя английский язык вообще не фигурировал в задаче. Это связано с тем, что внутреннее пространство модели, которое представляет собой область абстрактных семантических понятий (концептов), сформировано преимущественно на основе данных английского языка. Иными словами, как пишут исследователи, внутренним языком модели следует считать не английский язык, а язык понятий, у которых есть явный перекос в сторону английского, а «английский язык играет роль посредника не столько на лексическом уровне, сколько на семантическом».

Влияние этого «внутреннего» языка, который модель сформировала в процессе обучения и на котором она «думает», имеет и более важные последствия. Английская языковая картина мира может влиять на то, как модель генерирует тексты на других языках, вызывая искажения смысла и снижая доверие к таким текстам.

Еще на

эту тему

Приличное поведение больших языковых моделей может быть обманчивым

Попытки перевоспитать «спящих агентов» только ухудшают ситуацию

Нейросети проиграли людям при поиске грамматических ошибок

Это открытие ставит под сомнение языковые компетенции моделей

Чат-боты GPT и другие: что думают лингвисты о больших языковых моделях

Впереди демократизация порождения текстов и большие риски злоупотреблений