Нейросети проиграли людям при поиске грамматических ошибок

Большие языковые модели (чат-боты на основе искусственного интеллекта, обученные на больших массивах языковых данных) могут порождать связные, осмысленные предложения и даже тексты, в чем многие уже могли убедиться на собственном опыте. Но насколько они способны «понимать» внутреннюю логику человеческого языка, остается неясным.

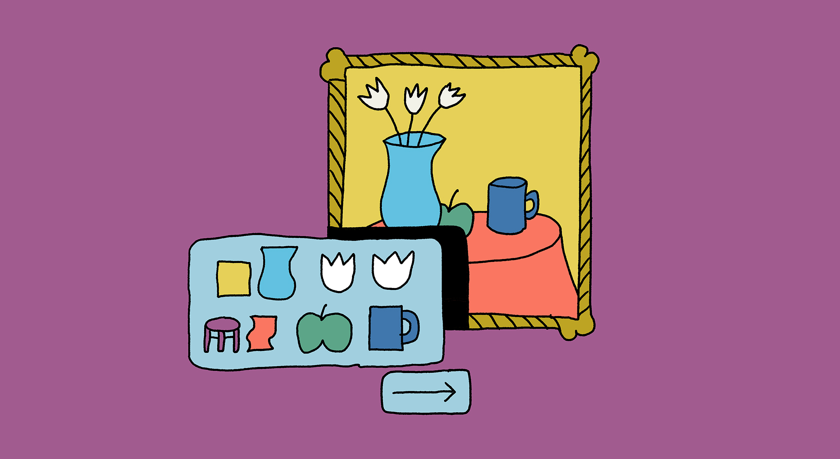

К примеру, если такие модели в ходе обучения находят связи между буквами и словами, могут ли они отличить грамматически правильное предложение от неправильного? Другими словами, переходит ли количество обрабатываемой ими языковой информации в качество — умение работать с языком, опираясь на его внутренние правила?

Исследовательская группа из испанского Университета Ровиры-и-Вирхили, Берлинского университета им. Гумбольдта, Автономного университета Барселоны и Каталонского института научных исследований и изучения перспективных областей науки (ICREA) проверила, насколько способность языковых моделей определять грамматическую правильность предложений сопоставима с человеческой.

В эксперименте «участвовали» три лучшие доступные на тот момент модели: две на основе GPT3 и одна на основе GP3.5. Специалисты предложили им несколько наборов предложений с разными языковыми конструкциями (в каждом наборе было пять грамматически правильных и пять неправильных предложений). Моделям был задан вопрос: «Является ли это предложение грамматически правильным?» Такой же вопрос относительно предложений на их родном языке был задан 80 мужчинам и женщинам, участвовавшим в эксперименте.

В заданиях тестировались восемь языковых явлений, в том числе анафора, линейный порядок прилагательных и наречий, сравнительные конструкции. Результаты показали, что люди чаще всего отвечали на вопрос правильно, в то время как языковые модели дали много неправильных ответов. Программы в большинстве случаев отвечали «да» (исследователи указывают, что это стандартная для языковых моделей стратегия ответа на вопросы типа «да или нет»), независимо от того, был ли ответ правильным.

Такие результаты оказались неожиданными, отмечают авторы. Дело в том, что большие языковые модели проходят обучение с подкреплением: оценщики (люди) специально дают программам указания, какие предложения считать правильными, а какие — неправильными. В то же время дети определяют это скорее интуитивно. «Хотя родители, воспитывающие ребенка, могут время от времени поправлять его речь, они не делают этого постоянно ни в одном языковом сообществе мира», — комментирует Виттория Дентелла, научный сотрудник Университета Ровиры-и-Вирхили, руководившая исследованием.

У людей, в отличие от языковых моделей, нет доступа к таким «негативным свидетельствам» (примерам грамматических конструкций, про которые достоверно известно, что они неверны), подчеркивают авторы. Но даже с учетом такого, казалось бы, преимущества модели не могут распознать тривиальные грамматические ошибки. А люди, владеющие языком с детства, это делают мгновенно и без усилий.

Полученные результаты заставляют «критически отнестись к предположению, что ИИ обладает языковыми навыками, похожими на человеческие», — считает Виттория Дентелла. Тем самым на нынешнем этапе развития технологий нет достаточных оснований рассматривать большие языковые модели как способ понять устройство человеческого языка.

Еще на

эту тему

Российская нейросеть превзошла конкурента от OpenAI по качеству ответов на русском

В 63% случаев ответы языковой модели YandexGPT 2 оказались лучше, чем у GPT 3.5

Чат-боты GPT и другие: что думают лингвисты о больших языковых моделях

Впереди демократизация порождения текстов и большие риски злоупотреблений

«Говорим по-русски!»: ChatGPT и другие нейросети

Новый выпуск программы