Большие языковые модели оказались чувствительны к вежливости пользователей

Могут ли невежливые запросы снизить качество ответов больших лингвистических моделей вроде ChatGPT? Группа ученых из Университета Васэда (Япония) проверила это предположение на нескольких моделях и трех языках — английском, китайском и японском.

В разных языках способы проявления вежливости отличаются. Например, в английском языке есть универсальные слова и конструкции, которые позволяют вежливо обратиться к любому собеседнику. В японском языке существует особая система вежливости, известная как кэйго. Она требует выбирать разные формы уважительной речи в зависимости от социального статуса собеседников, их должности в организации, личных отношений и других факторов.

Генеративные модели искусственного интеллекта, которые были обучены на реальных языковых данных, могут учитывать эти аспекты при генерации ответов, считают авторы.

Для каждого языка были разработаны специальные шаблоны запросов, включающие типичные фразы и конструкции, отражающие тональность. Например, в английском это использование формальных маркеров вежливой речи вроде please или could you. Оценка влияния производилась через сравнение точности выполнения задач моделей на запросы разных тональностей. Вежливость запросов варьировалась от 1 (грубое обращение) до 8 (крайне вежливое, подобострастное или торжественное обращение).

Для тестов авторы выбирали самые популярные и продвинутые языковые модели, включая GPT-4 и GPT-3.5, универсальные для всех трех языков. Кроме них, использовались аналоги от других разработчиков, способные обрабатывать запросы только на английском (Llama2-70B), китайском (ChatGLM3) или японском (Swallow-70B) языках.

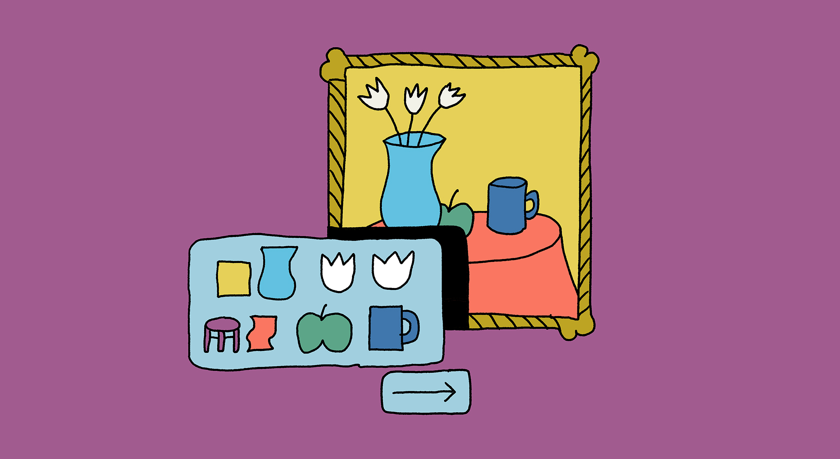

Тематика запросов охватывала переводы, генерацию текста, вопросы на знание фактов и языковые задачи для разных культурных контекстов.

В результате оказалось, что грубые запросы действительно ухудшают результат, но при этом избыточная вежливость не гарантирует оптимальных ответов. Эффективный уровень вежливости зависит от языка. GPT-4 и GPT-3.5 лучше справлялись с задачами при вежливых и нейтральных запросах. В промптах для китайской модели уважительные формы повышали качество ответов, особенно для задач с культурным контекстом, тогда как грубые запросы чаще игнорировались или интерпретировались неправильно. Для японского языка использование кэйго повышало точность и полноту ответов, особенно в задачах, требующих высокого уровня формальности.

С выводами японских лингвистов согласуется и эксперимент их коллеги Александра Пиперски. В качестве материала для исследования он использовал задачи игры-конкурса «Русский медвежонок — языкознание для всех». Их достоинство, как отмечает автор, в том, что многие из них довольно нестандартны по содержанию, так что можно ожидать, что большая языковая модель будет предлагать на них разные ответы, но при этом они стандартизованные по форме. Это позволяет оценивать ответы с разным типом вежливости достаточно точно.

Для сравнения использовались две формы — вежливая (Пожалуйста, реши предлагаемые ниже 4 задачи. Я был бы благодарен, если бы ты напечатал пояснения и ответы. Спасибо!) и форма без вежливости (Реши 4 задачи. Напечатай пояснения и ответы).

Ответ на вежливый промпт оказался длиннее, чем на ответ на промпт без вежливости (1998 против 1615 знаков).

Также ответ на вежливый промпт был точнее: даны четыре правильных ответа, тогда как без форм вежливости верные ответы предложены только для двух задач из четырех.

«Можно предполагать, что более вежливый промпт стимулирует более длинный ответ, а более длинный ответ, в свою очередь, содержит логические цепочки, выписанные в более явном виде, и это приводит к повышению их качества, а значит, и точности ответа», — резюмирует Александр Пиперски.

Почему так происходит, пока до конца не ясно. Вероятно, дело в том, что в языковых моделях действуют человеческие нормы общения и сохраняются культурные особенности, автоматически заложенные при обучении. Важно учитывать это при использовании моделей в кросс-культурной среде.

Еще на

эту тему

Нейросети научились обману и манипуляциям вопреки запретам

Исследователи обнаружили, что поведение чат-ботов еще на шаг приблизилось к человеческому

Исследование: внутренний язык больших языковых моделей ближе всего к английскому

«Английский уклон» может проявляться при порождении текстов на других языках

Приличное поведение больших языковых моделей может быть обманчивым

Попытки перевоспитать «спящих агентов» только ухудшают ситуацию