Проект по изучению языка Wordfreq закрылся из-за загрязнения данных нейросетями

В середине сентября Робин Спир, создательница проекта Wordfreq, который анализировал использование языка в интернете, объявила о том, что размещенная на нем информация больше не будет обновляться. В своем посте на платформе для разработчиков GitHub она объяснила свое решение тем, что среди данных для анализа оказалось слишком много «мусорных», и обвинила крупные компании, разрабатывающие генеративные нейросетевые модели, в создании «беспорядка».

Проект Wordfreq фиксировал частоту употребления лексики сорока с лишним языков, изучая статьи в «Википедии», субтитры к фильмам и передачам, новости, книги и посты в соцсетях. Система предназначалась для оценки языковых привычек людей, сленга и популярной культуры. Однако в последнее время присутствие сгенерированных искусственным интеллектом данных среди человеческих текстов стало настолько выраженным, что результаты перестали отражать языковое поведение человека.

Робин Спир утверждает, что «ни у кого нет надежной информации о том, как люди пользовались языком в период после 2021 года».

Спир отметила, что веб-скрейпинг (автоматизированный сбор данных с сайтов) был важным источником данных для проекта, но теперь интернет полон «мусора», который искажает сведения о частоте употребления слов. В качестве примера она привела «склонность» ChatGPT злоупотреблять словом delve (‘рыться’, ‘копать’), что повысило его частоту в общей выборке (хотя люди на самом деле не стали употреблять его чаще). Спир также отметила, что данные веб-скрейпинга стало сложнее добывать, так как платформы вроде Twitter (ныне носящий название X) и Reddit начали взимать плату за доступ к своим API.

Спир признала, что в данных Wordfreq всегда был спам, но раньше его можно было отследить и вычистить. Теперь же большие языковые модели генерируют текст, который маскируется под человеческий, и он всплывает повсюду. Она добавила, что проект Wordfreq был связан с обработкой естественного языка, но теперь сама область сильно изменилась: «...генеративный ИИ получает все деньги. Редко можно увидеть исследование в области естественного языка, которое не зависело бы от закрытых данных, контролируемых OpenAI и Google, — двумя компаниями, которые я презираю», — заявила Спир.

Еще на

эту тему

В онлайн-продаже обнаружены книги о сборе грибов, сгенерированные нейросетями

Эта проблема может привести к трагедии, предупреждают специалисты

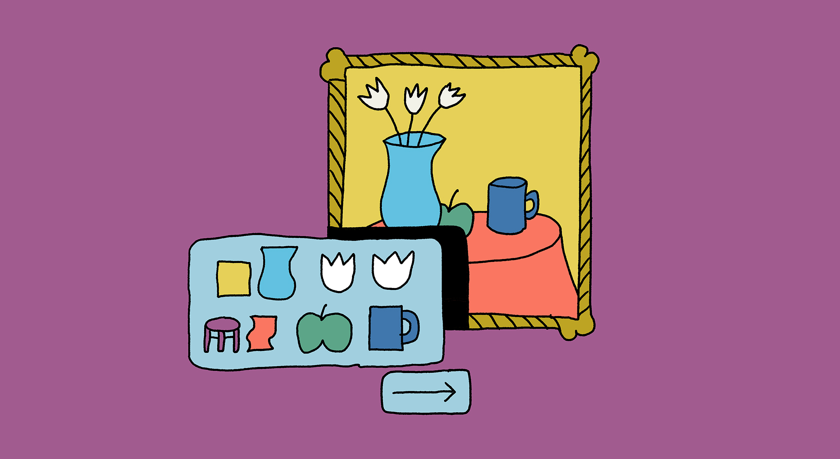

Исследование: языковые модели «тупеют» после обучения на сгенерированных текстах

Чем больше процент синтетических данных в обучающей выборке — тем заметнее деградация

Языковые модели оказались хорошими помощниками в написании рассказов — но не для всех

В способности к творчеству моделям пока далеко до человека