Польский и русский оказались эффективнее английского при поиске информации

Недавнее исследование, проведенное учеными из Microsoft и ведущих американских университетов, опровергает идею, что нейросети всегда лучше работают с теми языками, для которых есть большие массивы текстов.

При генерации или переводе текстов действует общее правило: чем больше данных для обработки доступно модели на этапе обучения, тем лучше будет результат. Например, ИИ-перевод на языки вроде английского и русского получается точнее, чем на менее распространенные — скажем, на сербский или армянский.

Однако к задачам, связанным с поиском нужной информации в тексте, эта логика оказалась неприменима.

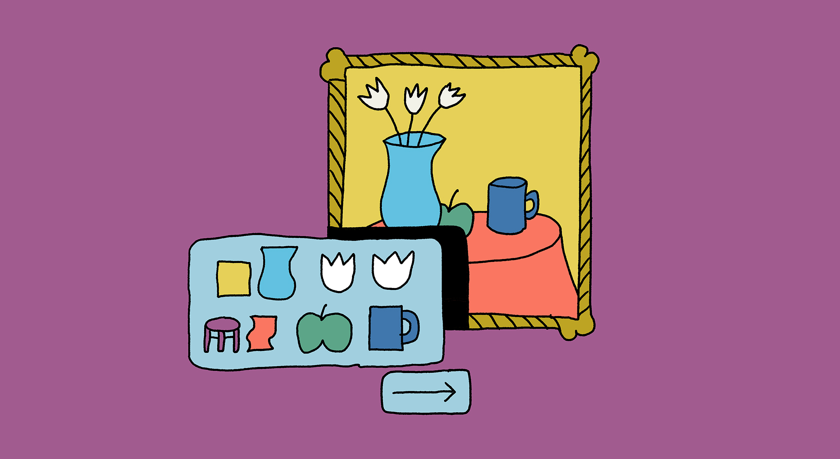

Для проверки гипотез был создан специальный многоязычный стресс-тест: модели должны были найти информацию в тексте на одном из 26 языков. Причем им намеренно затрудняли работу, используя принцип иголки в стоге сена. Стог сена — это 100–200 страниц несвязного текста. Иголка — крошечный, но важный факт, который нужно найти (например, имя или номер). Эту «иголку» прятали в разных, часто самых неожиданных, местах документа (в некоторых случаях иголки на самом деле не было).

Таким образом авторы проверяли, может ли модель удерживать информацию в фокусе своего «внимания», пока просматривает тысячи слов, и не «забывает» ли она ключевые данные, находящиеся в самом начале текста, к тому моменту, когда дойдет до конца. Авторы назвали свой инструмент OneRuler, имея в виду, что он позволяет измерять качество работы моделей применительно к разынм языкам «на один аршин».

Тестирование шести продвинутых моделей (включая Gemini 1.5 Flash и Llama 3.3) на материале 26 языков принесло неожиданные результаты в самых сложных задачах: на первом месте оказался польский язык с 88% точности, а английский — только на шестом (83,9%). К слову, русский попал в пятерку лидеров. А вот в аутсайдерах оказался китайский (62%).

Почему польский, который имеет меньший объем текстовых данных для обучения моделей, чем английский или китайский, обошел их в этом тесте?

Исследователи предполагают, что дело случае задач на поиск важнее оказывается не объем данных, а в их качество и структура языка. Польский отличается морфологическим богатством (наличием показателей грамматического рода и падежа). Представим, что английский язык — это конструктор лего, где каждое слово-деталь (местоимение, предлог) лежит отдельно, но легко соединяется со множеством других деталей. А польский больше похож на пазл, где у одних элементов есть явные места сочленения с другими. Возможно, за счет этих подсказок, заключенных в самой языковой структуре, модель получает больше полезной информации.

Китайский в этом отношении неудобен для языковых моделей. Он относится к изолирующим языкам: грамматические значения в нем передаются порядком слов и служебными словами, а не изменением формы слова путем «приклеивания» суффиксов или префиксов. Если учесть это, становится понятным, почему он показал себя сравнительно плохо. Впрочем, это лишь гипотеза, которая требует проверки.

Еще на

эту тему

Могут ли нейросети написать «Войну и мир» и куда они заведут человечество

На форуме «Территория будущего. Москва 2030» рассказали о возможностях ИИ

Исследование: внутренний язык больших языковых моделей ближе всего к английскому

«Английский уклон» может проявляться при порождении текстов на других языках

Нейросети проиграли людям при поиске грамматических ошибок

Это открытие ставит под сомнение языковые компетенции моделей